¿Cómo guiar a Google sin bloquear lo que realmente importa?

Muchos problemas de indexación no se deben al contenido. Se deben a una mala configuración técnica. Y dos de los elementos más críticos en ese proceso son el archivo robots.txt y el sitemap XML.

Cuando están bien configurados:

• Google rastrea mejor

• Se optimiza el crawl budget

• Se indexa lo importante

Cuando están mal configurados:

• Se bloquean páginas clave

• Se envían señales contradictorias

• Se pierde visibilidad sin saber por qué

¿Qué es robots.txt y qué controla realmente?

Si te preguntas qué es robots.txt, la respuesta es simple: robots.txt es un archivo que indica a los motores de búsqueda cómo deben rastrear tu sitio.

El archivo robots txt se encuentra normalmente en:

tudominio.com/robots.txt

Su función es dar instrucciones a los bots sobre:

• Qué se puede rastrear

• Qué no debe rastrearse

📌 Importante el archivo robots: controla el rastreo, no la indexación directa.

Muchos errores SEO nacen de una mala comprensión de esto.

Bloquear una URL en robots txt un archivo no garantiza que desaparezca de Google.

En términos técnicos, los archivos robots txt funcionan como una puerta de acceso para los crawlers.

Ejemplo básico correcto:

User-agent: *

Disallow: /admin/

Disallow: /carrito/

Sitemap: https://tudominio.com/sitemap.xml

¿Qué es un sitemap XML y para qué sirve?

El sitemap XML es un archivo que lista las URLs que quieres que Google descubra e indexe.

Ubicación habitual:

tudominio.com/sitemap.xml

Su función es:

Facilitar el descubrimiento de URLs

Indicar páginas prioritarias

Mejorar eficiencia de rastreo

📌 Un sitemap no garantiza indexación, pero facilita el proceso.

¿Cómo deben trabajar juntos robots.txt y sitemap?

Ambos archivos deben estar alineados.

Regla clave:

Robots.txt bloquea lo irrelevante

Sitemap destaca lo importante

❌ Error frecuente: incluir en el sitemap URLs que están bloqueadas en robots.txt.

Eso genera señales contradictorias.

Configuración correcta paso a paso

1- Define qué páginas son estratégicas

Incluye en el sitemap:

Categorías

Productos principales

Artículos relevantes

Landings clave

2- Limpia el sitemap

Solo deben aparecer:

URLs con código 200

URLs indexables

URLs canónicas

No incluyas:

Páginas con noindex

URLs redirigidas

Parámetros innecesarios

3- Optimiza robots.txt

Bloquea:

Áreas privadas

Filtros infinitos

Resultados de búsqueda interna

Parámetros sin valor SEO

Permite:

CSS y JavaScript necesarios para renderizado

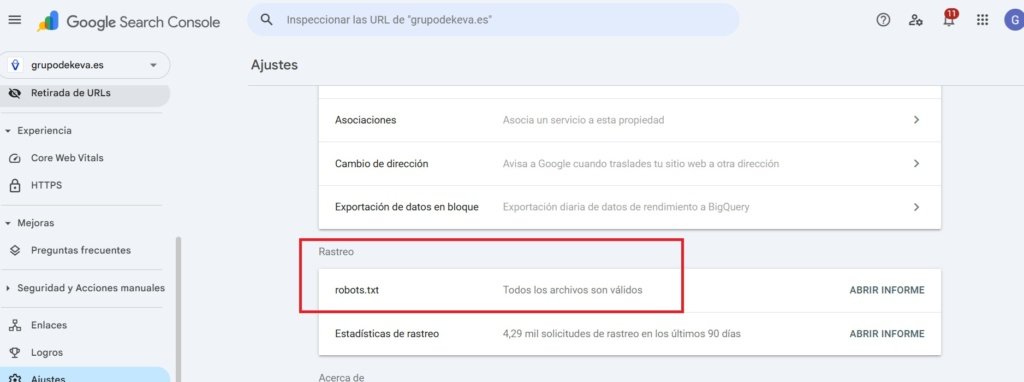

4- Valida en Search Console

Revisa:

Informe de páginas excluidas

Errores de rastreo

Problemas de cobertura

Robots.txt en WordPress: dónde está, cómo se crea y cómo se actualiza

En WordPress, el archivo robots txt puede existir de dos formas: como robots.txt un archivo físico en tu servidor, o como un robots.txt virtual que WordPress “genera” automáticamente si no detecta uno real en la raíz del dominio.

Dónde se encuentra el archivo robots.txt en WordPress

La ubicación correcta siempre es la misma:

tudominio.com/robots.txt

Si al entrar ahí ves un contenido básico, significa que WordPress está sirviendo un robots virtual o ya tienes un archivo robots txt creado.

Cómo crear un archivo robots en WordPress

Para crear un archivo robots tienes 3 caminos (de más simple a más profesional):

Plugin SEO (Rank Math / Yoast / etc.)

Te dejan editar el contenido desde el panel. Es rápido, pero debes revisar que no bloquee cosas importantes.Archivo físico en la raíz del hosting (recomendado si quieres control total)

Subes robots.txt un archivo al directorio principal del dominio. Esto “manda” por encima del robots virtual.Edición vía FTP o administrador de archivos (cPanel / hosting)

Ideal si estás trabajando un proyecto serio y quieres evitar limitaciones del plugin.

📌 Importante el archivo robots: si existe un archivo físico, Google usará ese, no el virtual.

Plugins para gestionar robots.txt en WordPress

En entornos robots txt en WordPress, muchos administradores prefieren usar plugins en lugar de editar manualmente el servidor. No es incorrecto, pero es importante entender sus implicaciones.

Un plugin no “crea magia SEO”.

Simplemente permite crear un archivo robots o actualizar un archivo robots desde el panel de WordPress.

¿Cuándo tiene sentido usar plugins para el archivo robots txt?

Usar plugins puede ser útil cuando:

• No tienes acceso al hosting o FTP

• El proyecto es pequeño o informativo

• Necesitas cambios rápidos sin tocar servidor

• El equipo no es técnico

Sin embargo, en proyectos SEO serios, conviene saber que robots txt un archivo físico siempre tiene prioridad sobre el virtual generado por plugins.

📌 Importante el archivo robots: si existe un archivo real en la raíz, WordPress y los plugins quedan en segundo plano.

Plugins populares para editar archivos robots txt

Los plugins SEO más utilizados permiten modificar el archivo robots txt fácilmente:

• Rank Math

• Yoast SEO

• All in One SEO

• SEOPress

Estos plugins generan o editan archivos robots txt virtuales sin necesidad de subir archivos manualmente.

Errores comunes que afectan al SEO

Bloquear toda la web por accidente

User-agent: *

Disallow: /

Esto bloquea todo el sitio.

Bloquear recursos críticos (CSS o JS)

Puede impedir que Google renderice correctamente la página.

Sitemap con URLs innecesarias

Enviar miles de URLs irrelevantes diluye la señal estratégica.

No actualizar el sitemap tras migraciones

Puede provocar indexación de URLs antiguas o errores 404 masivos.

Robots.txt, sitemap y crawl budget

En webs grandes, esta configuración es crítica.

Si Google rastrea:

Filtros infinitos

Páginas duplicadas

URLs con parámetros

Estará desperdiciando crawl budget.

Una buena configuración:

✔️ Reduce ruido

✔️ Mejora eficiencia

✔️ Aumenta indexación estratégica

Conclusión

Robots.txt y sitemap XML no son archivos técnicos secundarios. Son herramientas estratégicas para guiar a Google.

Bien configurados:

Mejoran rastreo

Optimizan crawl budget

Aumentan eficiencia de indexación

Mal configurados:

📩 Escríbenos a info@grupodekeva.es

💬 O contáctanos directamente por WhatsApp y descubre cómo multiplicar tus resultados con campañas inteligentes y asistentes IA que trabajan 24/7 para ti.

✨ Dekeva – Donde la estrategia se une con la Inteligencia Artificial para que tu negocio crezca sin límites.

Generan bloqueos invisibles

Envían señales contradictorias

Frenan el crecimiento SEO

En SEO técnico, claridad y coherencia lo son todo.

Preguntas frecuentes sobre robots.txt y sitemap XML

No directamente. Solo bloquea el rastreo, no la indexación automática.

No es obligatorio, pero es muy recomendable, especialmente en webs grandes.

No es recomendable. Genera señales contradictorias para Google.

Siempre que añadas o elimines URLs importantes.

Sí. Un bloqueo incorrecto puede impedir el rastreo completo de la web.