La clave oculta del SEO técnico cuando tu web tiene miles de URLs

Cuando una web empieza a crecer, aparece un problema que muchos ignoran hasta que ya es grave: Google no rastrea todo lo que debería. No porque no quiera, sino porque tiene un límite. Ese límite es el crawl budget.

En webs grandes, el SEO ya no va solo de contenido o enlaces. Va de priorizar qué URLs ve Google, cuándo las ve y con qué frecuencia. Si no controlas el crawl budget, puedes tener miles de páginas “invisibles”.

¿Qué es el crawl budget? (explicado sin rodeos)

El crawl budget es la cantidad de URLs que Googlebot puede y quiere rastrear en tu web durante un periodo de tiempo.

Depende principalmente de dos factores:

Capacidad de rastreo → qué tan rápido responde tu servidor

Demanda de rastreo → qué páginas considera Google importantes

📌 Idea clave: si Google pierde tiempo rastreando URLs inútiles, no llega a las que sí importan.

Cuándo el crawl budget se convierte en un problema

En webs pequeñas, casi nunca.

En webs grandes, es crítico.

Especialmente en:

Ecommerce con filtros y parámetros

Medios con miles de URLs antiguas

Marketplaces

Webs con facetas, búsquedas internas o paginaciones infinitas

Señales claras de problema:

Páginas importantes no indexadas

Rastreo excesivo de URLs sin valor

Alto número de “Descubierta, no indexada”

Googlebot gastando recursos en parámetros

Cómo Google decide qué rastrear primero

Google prioriza:

URLs con enlaces internos fuertes

Contenido actualizado con frecuencia

Páginas con señales de autoridad

URLs limpias y coherentes

Y relega:

URLs duplicadas

Parámetros infinitos

Páginas pobres o repetidas

Errores y redirecciones innecesarias

El crawl budget no se aumenta, se optimiza.

Cómo optimizar el crawl budget en webs grandes

1. Elimina URLs inútiles del rastreo

Identifica y controla:

Parámetros innecesarios

Filtros sin valor SEO

Resultados de búsqueda interna

URLs duplicadas

Acciones:

noindexBloqueo selectivo en robots.txt

Canonicals bien aplicados

2. Mejora la arquitectura y el enlazado interno

Google rastrea mejor lo que está mejor enlazado.

Buenas prácticas:

Jerarquía clara

Menos niveles de profundidad

Enlaces internos hacia páginas clave

Evitar huérfanas

📌 Regla práctica: lo importante debe estar a pocos clics de la home.

3. Optimiza la paginación y facetas

Errores comunes:

Paginaciones infinitas

Facetas indexables sin control

Soluciones:

Control de facetas con noindex o canonical

Paginación lógica y enlazada

Evitar combinaciones infinitas de URLs

4. Reduce errores técnicos y redirecciones

Cada error consume crawl budget.

Revisa:

Errores 404

Redirecciones en cadena

URLs antiguas sin limpiar

Un sitio “limpio” se rastrea mejor.

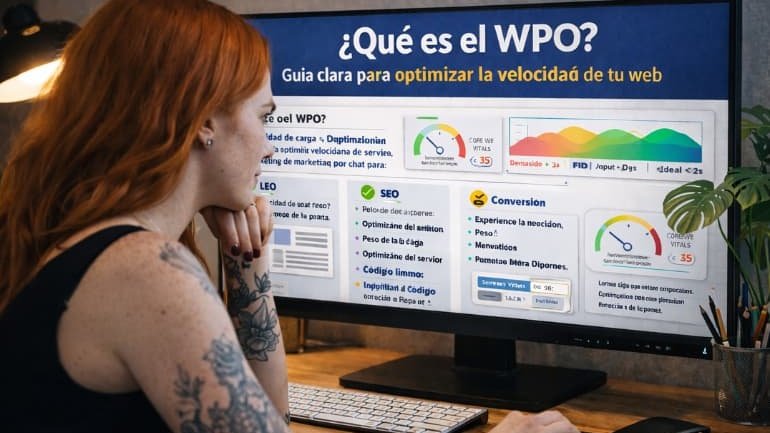

5. Asegura buen rendimiento del servidor

Si el servidor es lento, Google reduce el rastreo.

Claves:

Buen hosting

Tiempo de respuesta bajo

Core Web Vitals optimizados

📌 El rendimiento técnico impacta directamente en el crawl budget.

El error más común con el crawl budget

👉 Bloquear sin estrategia.

Bloquear URLs sin entender su impacto puede:

Cortar el flujo de autoridad

Dejar páginas importantes sin rastrear

Romper la arquitectura SEO

Optimizar el crawl budget no es cerrar puertas, es guiar a Google.

Conclusión

El crawl budget no es un concepto teórico, es una limitación real que afecta directamente al SEO de webs grandes. Cuando lo optimizas:

Google rastrea lo importante

La indexación mejora

El SEO escala mejor

Se aprovecha el esfuerzo de contenido

En webs grandes, el SEO ya no va de más contenido, sino de mejor rastreo.

📩 Escríbenos a info@grupodekeva.es

💬 O contáctanos directamente por WhatsApp y descubre cómo multiplicar tus resultados con campañas inteligentes y asistentes IA que trabajan 24/7 para ti.

✨ Dekeva – Donde la estrategia se une con la Inteligencia Artificial para que tu negocio crezca sin límites.

preguntas frecuentes

Sí, pero solo es crítico en webs grandes o con muchas URLs.

Indirectamente sí, si Google no rastrea o indexa páginas importantes.

No. Debe hacerse de forma estratégica para no afectar al SEO.

Sí, Google puede rastrear la URL aunque no la indexe.

En Google Search Console, analizando cobertura, rastreo y logs del servidor.